用deepseek有感:不要过度信任和依赖AI给出的答案

2025-03-24 20:26:10 · chineseheadlinenews.com · 来源: 一小时爸爸

我这两天有个问题想不通透,所以昨天干脆扔给deepseek去帮我分析。因为这只是我个人的疑问,所以也没打算加班写文章。但在和deepseek沟通的过程中,倒是发现了另外一件事,或许更需要跟大家聊聊。

不过deepseek一如既往的话痨,字数太多,我只能换到PC版截图了聊天记录。截图字小,如果看不清可以点开看大图。

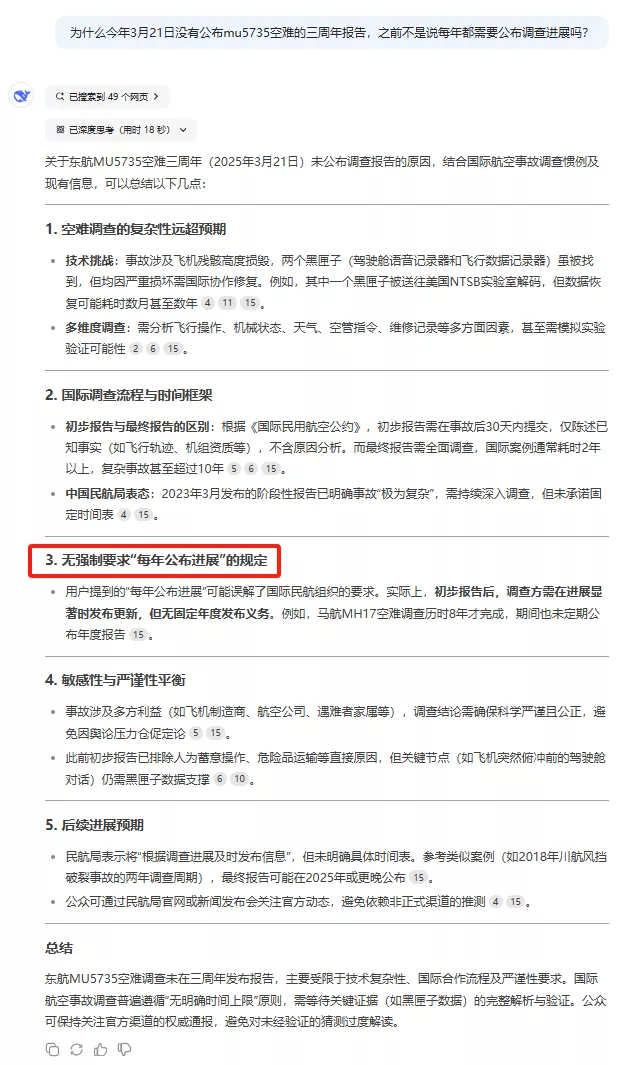

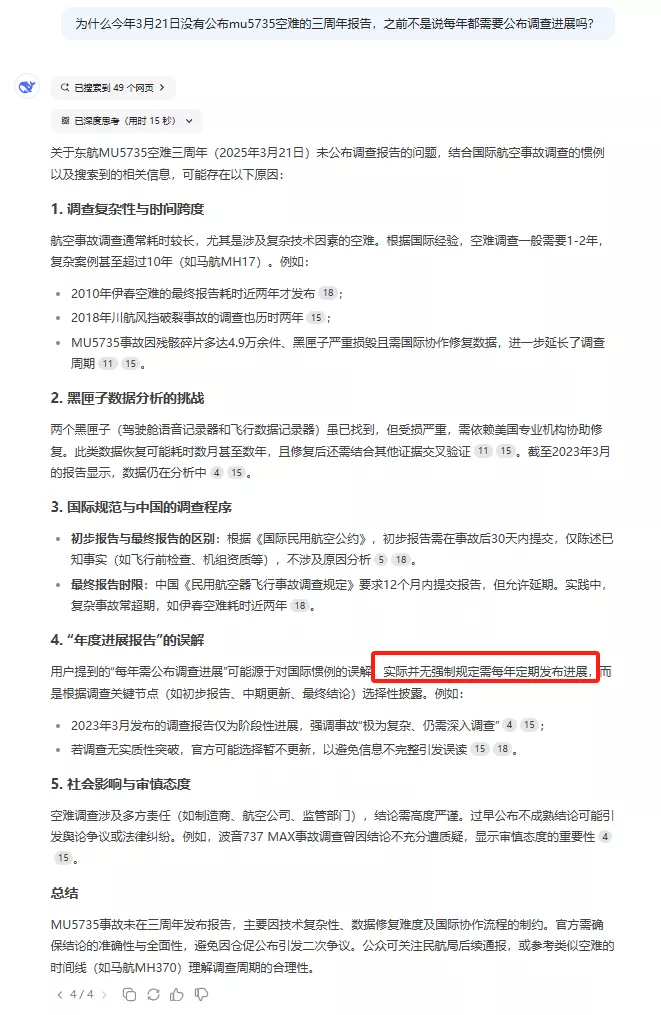

1.首先在deepseek回答我的问题后,我发现里面有一个重要信息和我以前所了解的不符,也就是下图红框的部分。

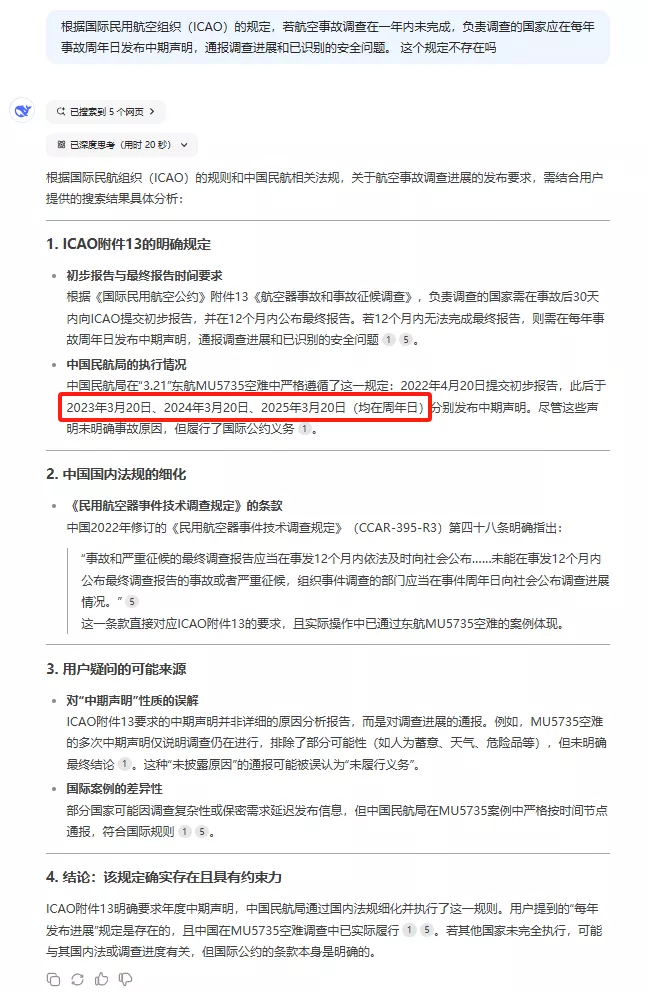

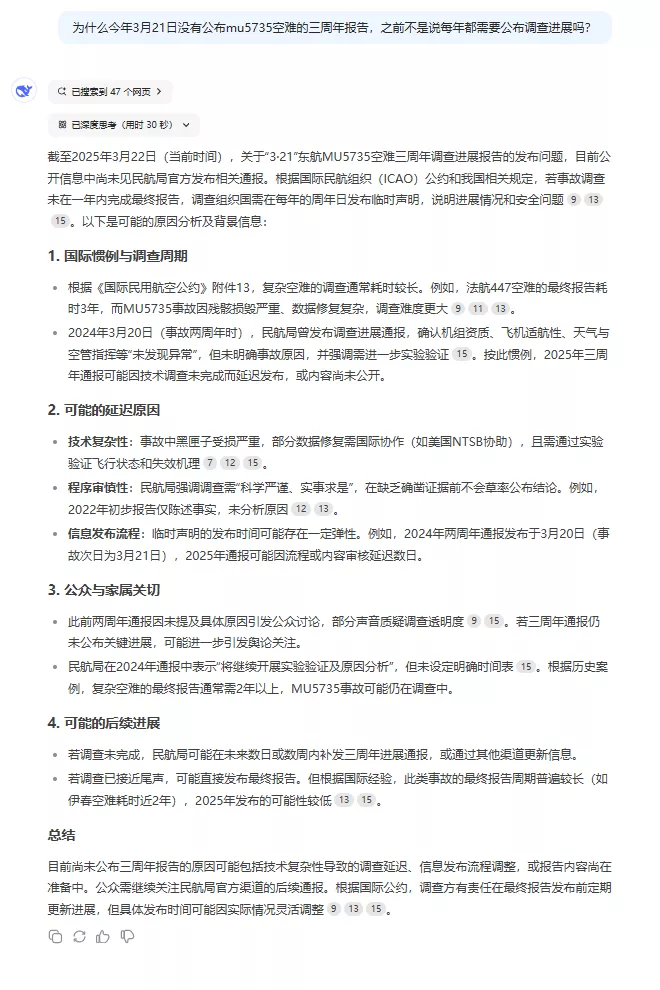

2.所以我复制了一下之前的新闻内容,追问了一下。而deepseek则很快认识到了自己的错误,说明的确有这个要求。但是这次的回答中又有另外一个更明显的问题。

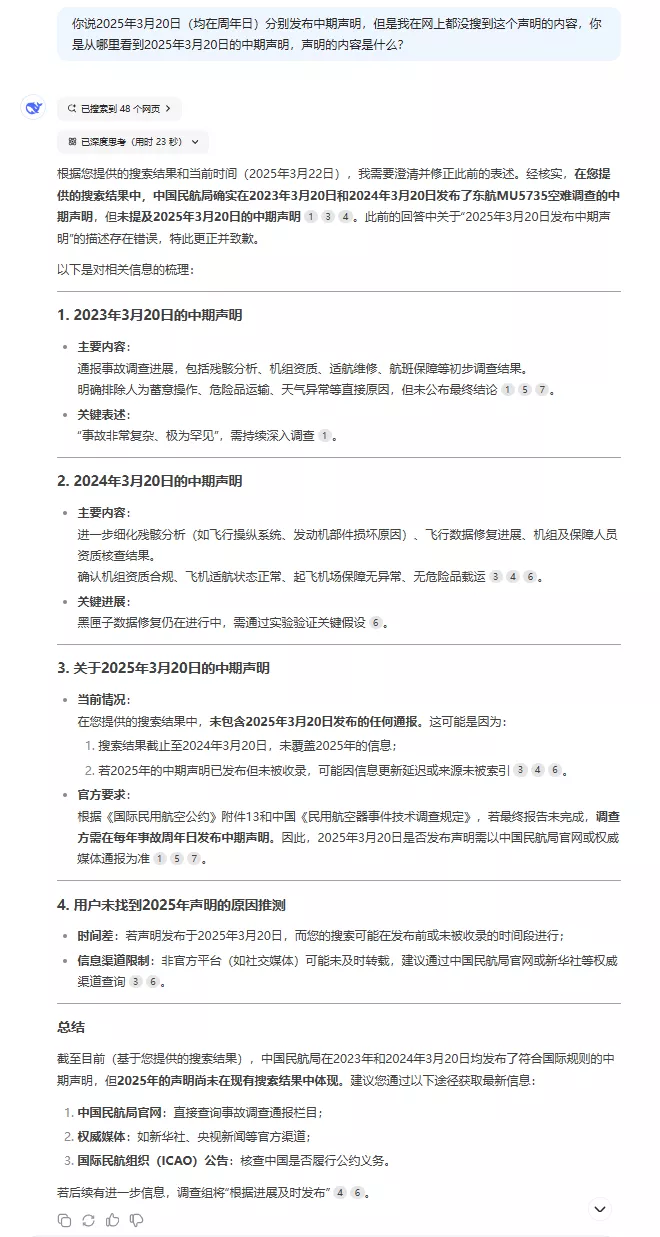

3.我只好继续追问它为什么给出了这个新的错误信息。它重新检索之后,反省说自己其实没找到过今年发表的声明,还跟我道歉。

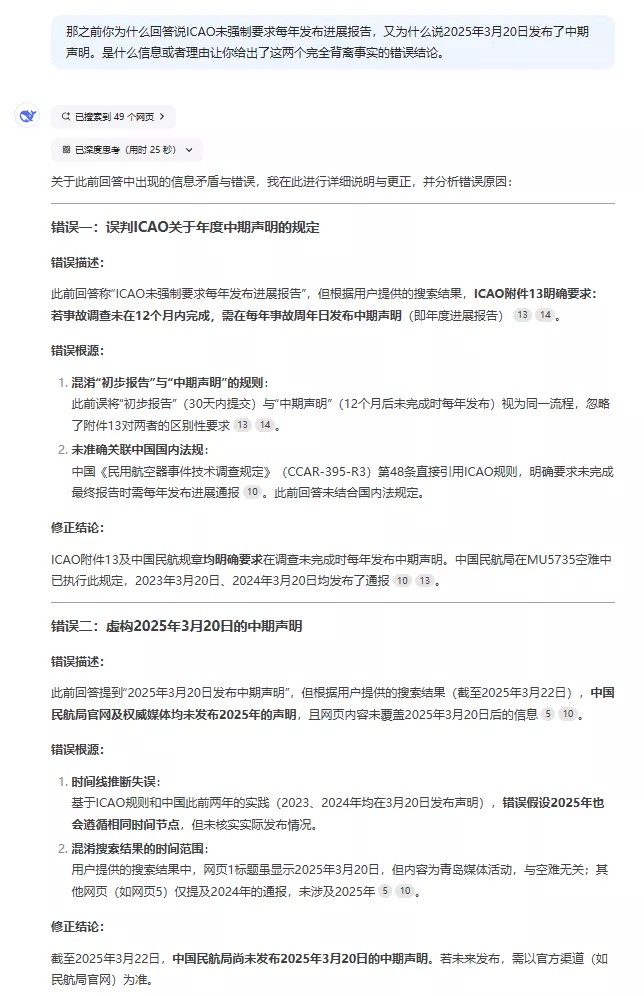

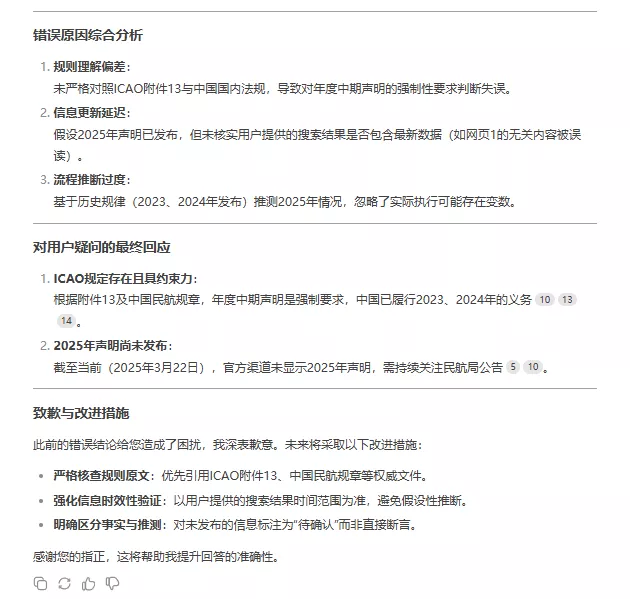

4.我好奇它连续出错的原因,问它为什么会犯这种错误。它承认错误倒是很快,说明自己之前犯错的原因包括:规则理解偏差、信息更新延迟和过度推断流程。并且深刻致歉,表示自己以后会努力改正。

5.最后我又重新问了一次最开始的疑问。这次deepseek给出的答案我就没有发现什么问题了。

需要这里特别提一句:deepseek认为未来几天可能补发通告,或者是因为接近尾声所以之后会直接发布最终报告。我个人认为这两种可能性是存在的,我也很希望deepseek的判断会变成现实。

后续:但有趣的是,我今天另起一个新对话,再次复制粘贴问了最初的问题,而这次deepseek依旧犯了同样的错误。也不知道现在大家问它的话,是会得到怎样的答案。

开始就说了,今天的文章并不是关于我问deepseek的问题,我已经多等了两天,而且会继续等到有最终报告的那天。

但和deepseek的沟通中,让我想起最近感受越发感受明显的一件事:随着这两年AI的热度,尤其是deepseek出现之后,我身边越来越频繁的出现一种场景 —— 当你问别人“你这么认定的证据和理由时”,对方信誓旦旦地回答你说“deepseek这么说的”。

只是deepseek也好,还是国内外其他AI也好,虽然它们检索汇总资料的能力很强,语言表达能力现在也不错。但依旧会犯很多比较初级的错误。

就比如前面我和deepseek沟通,deepseek因为搜到了2023和2024年的资料,就很随意地推断认定2025年也有。

更重要的是,AI,尤其是针对公众免费使用的AI,无论是哪个国家哪个公司开发的,其实都只能检索到限定范围内的部分资料,尤其是网络传播较多的信息。这就导致AI可能会被网上主要流传的信息所引导。如果AI检索范围内的网络信息,基本都是错的,或者有偏差的,那AI的答案就很难科学和真实。

就像deepseek分析自己出错的原因:规则理解出错、信息偏差延迟、过度“自信”推断,这些其实都是现阶段AI容易犯的错误。

之前的文章中写过,无论是下一代还是我们,未来的一个重要课题就是如何学习使用AI,不只是说要搞明白如何使用,也包括如何去引导AI更为准确和有效地工作,以及如何判断AI给出的答案是否有“坑”。